Legge della miseria crescente (3)

Risposte spiacevoli dalla dinamica dei sistemi

Spiacevoli per i borghesi, naturalmente. Quando Turing, Von Neumann e altri "inventarono" il computer, non esisteva ancora la macchina, ma solo un modello mentale. Eppure erano già in grado di affermare che quella macchina avrebbe potuto risolvere qualunque tipo di problema. Con sufficiente spazio per memorizzare i risultati parziali, l'incognita sarebbe stata solo il tempo. Naturalmente tutti sanno che anche un supercomputer non è in grado di fare previsioni meteorologiche a tre giorni; tuttavia persino un personal computer da quattro soldi è in grado di aiutarci a generare un modello meteorologico e mostrarci la simulazione realistica di un tornado. La nostra conoscenza del mondo è aiutata più dai risultati della simulazione che non dal sapere se domani piove.

Un modello al computer è formulato in termini espliciti con un linguaggio meno ambiguo di quello parlato o pensato. Tale linguaggio può essere compreso da tutti indipendentemente dal livello di preparazione e può riprodurre qualsiasi cosa si possa dire a voce, purché non contenga ambiguità o contraddizioni. Non si adatta alle chiacchiere degli economisti e dei politici di professione. Un modello di simulazione del mondo del tipo di cui stiamo parlando rappresenta la struttura delle relazioni entro il mondo stesso e soprattutto si alimenta più di quantità fisiche che di valori in denaro. Se ad esempio si immette il dato sulle riserve di petrolio in relazione ai consumi e alle nuove scoperte di giacimenti, è chiaro che si avrà la risposta sulla durata del sistema basato sull'energia da idrocarburi. Lo stesso discorso vale per quanto riguarda la produzione industriale, l'inquinamento e la popolazione. Così, mentre cresce il Prodotto Interno Lordo e i capitalisti celebrano la loro presunta vittoria sul comunismo, i loro modelli dimostrano il fallimento del capitalismo. Mentre il linguaggio parlato esprime ciò che è dettato dall'ideologia dominante, il linguaggio macchina esprime il comportamento del sistema reale:

"Questi modelli ci spiegano perché oggi ci troviamo in difficoltà all'interno dei nostri sistemi sociali e perché sono falliti i numerosi tentativi fin qui condotti di migliorarne il funzionamento" (Forrester, op. cit.).

Ma perché i sistemi sociali si dimostrano così insensibili alle "riforme" tese a migliorare le condizioni di vita dei cittadini o anche solo a programmare la cosiddetta crescita economica? Gli sviluppatori di programmi per la dinamica dei sistemi sono arrivati alla conclusione che, a causa del modo di pensare corrente, l'attenzione degli economisti è attratta proprio da quegli elementi dei sistemi stessi che più sono insensibili agli interventi riformistici. Infatti l'esperienza umana è condizionata da millenni di consuetudine con sistemi lineari semplici, adatti ad un'esistenza non alienata, in cui l'uomo non è ancora separato completamente dai mezzi di produzione e ha buone possibilità di trovare la soluzione dei problemi là dove si manifestano i sintomi del malfunzionamento. Invece, in un sistema sociale complesso come il capitalismo, le cause del malfunzionamento non sono quasi mai simultanee al sintomo e nemmeno lo precedono di poco: esse andrebbero ricercate non là dove si manifesta il sintomo ma nella dinamica delle retroazioni provenienti dai livelli più alti del sistema stesso. Per questo gli interventi dei governi nell'economia non riescono a risolvere il problema, cioè non si discostano mai da una rincorsa fra lo strappo e la toppa.

Sembra ragionevole ricercare la causa della miseria in una mancanza di capitali, e non si vede che essa è provocata invece da troppi investimenti. Non è raro trovare nei saggi degli economisti il concetto secondo il quale per aumentare la ricchezza occorre aumentare la produttività, mentre è assiomatico che un aumento della produzione pro capite libera in massa forza-lavoro, fa rimanere molti senza reddito e obbliga a distribuire quello globale, con una diminuzione netta nella media statistica. Sembra ragionevole immaginare che la miseria sia provocata dall'aumento della popolazione, dato che in questo caso occorre dividere la ricchezza fra un numero crescente di persone, se la massa del prodotto non aumenta conseguentemente. Sembra ancor più ragionevole immaginare che il divario fra paesi ricchi e poveri sia proprio dovuto al sommarsi di poca produzione e molta popolazione in molti di essi. Anche qui l'intervento, sia dei governi locali che degli organismi mondiali, si basa sull'incremento del capitale investito e dell'industrializzazione, mentre i modelli computerizzati, inesorabilmente,

"…suggeriscono che la sola speranza è rappresentata da una riduzione del ritmo di industrializzazione, che può in realtà aiutare a elevare la qualità della vita e a stabilizzare il livello di popolazione… L'industrializzazione può avere sull'ecologia mondiale un effetto di disturbo molto più rilevante che non la popolazione: infatti è forse più corretto considerare l'esplosione demografica come un risultato della tecnologia e dell'industrializzazione" (Forrester, op. cit.).

Fermiamoci un attimo su questa testimonianza, che è di per sé una gigantesca capitolazione di fronte alla legge della miseria crescente di Marx (o legge della popolazione). È evidente che i modelli di trent'anni fa offrivano già gli strumenti per capire la dinamica dello sviluppo e della "formazione del reddito" e che quelli attuali, più affinati nella loro capacità di simulazione della realtà, non presentano soluzioni diverse, anzi, sono più catastrofici ancora. Ci sarebbe da chiedersi come mai gli uomini tengano un comportamento così strano, tanto da sviluppare queste simulazioni, leggerne le indicazioni pubblicando centinaia di saggi su di esse, per poi fare tutto il contrario di ciò che esse insegnano.

Il fatto è che il capitalismo non può fare a meno di una crescita esponenziale e qui − è un altro assioma − non ci sono scappatoie: tale tipo di crescita ha un limite. Ricordiamo la parabola degli ecologisti sul lago delle ninfee: ammettiamo che la pianta cresca in modo esponenziale raddoppiando la sua biomassa ogni giorno; quanti giorni mancheranno alla copertura totale del lago quando essa sarà giunta a coprirne la metà? Risposta: un giorno. I processi che nel capitalismo possono provocare la saturazione a causa della crescita esponenziale sono molti e non tutti immediatamente avvertibili. Ad esempio non è avvertibile la soglia di sopportazione di una massa di uomini di fronte al divario del reddito: fino al giorno prima di una eventuale esplosione sociale tutto sembra tranquillo, c'è tanto posto nel "lago delle ninfee". Ma la macchina con il suo programma di simulazione non si inganna; può sbagliare i tempi se non dispone di una serie passata, ma non può ingannare sé stessa sulla dinamica del sistema a crescita esponenziale. E allora è altrettanto evidente che, se le decisioni degli uomini non sono coerenti con le indicazioni oggettive che scaturiscono dal sistema, sarà inevitabile che il sistema stesso trovi la soluzione e muova spontaneamente verso uno sbocco: coinvolgendo naturalmente masse di uomini, portate a cercarlo in un sistema di ordine superiore e ad organizzarsi allo scopo.

Questo sistema ha già raggiunto il suo culmine

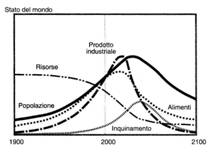

E quindi siamo sicuramente in discesa verso la catastrofe. Fra i primi modelli dinamici del capitalismo sviluppati al MIT, i più ottimisti prevedevano (alla fine degli anni '60) che, se non vi fosse stato un radicale cambiamento nel modo di governare il mondo nei successivi cento anni, l'umanità si sarebbe trovata a regredire verso forme sociali inferiori a quella attuale (Forrester). I più pessimisti (quelli dei primi anni '70) avevano stabilito che il punto di non ritorno sarebbe giunto intorno al 1975 e che la società capitalistica si sarebbe estinta prima del 2100 (Meadows). Quei modelli, a parte le previsioni temporali, rispondevano abbastanza univocamente alle domande sul futuro della nostra specie: 1) ci sarebbe stata l'estinzione della moderna società industriale per l'impossibilità di avere materie prime, energia e risorse naturali in quantità proporzionale alla crescita; 2) inquinamento, malattie, guerre, mancanza di alimenti e sommosse sociali avrebbero contrassegnato un periodo di declino; 3) di conseguenza vi sarebbe stato un collasso della popolazione mondiale.

Qualunque cosa si possa dire di questi modelli, non si può negare che essi, mentre i loro stessi autori scrivevano libri sulla falsariga della teoria malthusiana della popolazione, consideravano l'aumento di quest'ultima come risultato dell'industrializzazione e il suo collasso come effetto della de-industrializzazione. Mai il contrario. Essi confermano dunque che la legge della miseria crescente è nello stesso tempo legge dell'accumulazione crescente e della popolazione.

Figura 6. Andamento dei fattori della produzione con la semplice proiezione dei dati 1992.

Figura 6. Andamento dei fattori della produzione con la semplice proiezione dei dati 1992. Figura 7. Andamento dei fattori della produzione con la

proiezione dei dati 1992 ma con l'ipotesi che dal 1995 una politica demografica

permetta di limitare le nascite a due figli per coppia (stabilità della

popolazione mondiale).

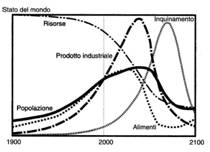

Figura 7. Andamento dei fattori della produzione con la

proiezione dei dati 1992 ma con l'ipotesi che dal 1995 una politica demografica

permetta di limitare le nascite a due figli per coppia (stabilità della

popolazione mondiale).Ora, l'accumulazione langue nei paesi più industrializzati e quindi, giusta la legge marxiana, langue anche l'incremento demografico. Questo è un comportamento anti-intuitivo del sistema e fa impazzire gli economisti. Che prima si lamentavano dell'aumento della popolazione come causa della miseria; adesso si lamentano dell'invecchiamento della popolazione stagnante che causa miseria. Eppure i modelli di simulazione suggeriscono da trent'anni che col capitalismo non c'è soluzione. Essi segnalavano l'andamento positivo dell'economia e lo sbocco negativo della società: il moderno industrialismo porta a un'alta produzione − teoricamente senza limiti − di beni materiali e di alimenti. Il ritmo di crescita è stato superiore a quello della popolazione, quindi c'è stato un lasso di tempo che sembrava promettere l'elevamento del "tenore di vita". Elevamento comunque relativo, dato che occorre tener conto dell'intera popolazione mondiale e non solo di quella dei paesi più industrializzati. L'assunto empirico, comune a Marx e ai malthusiani, secondo il quale a produzione industriale senza limiti teorici si contrappone una produzione agraria contraddistinta dai limiti fisici della terra disponibile e del ciclo stagionale, è aggravato enormemente dall'agire della legge marxiana: l'intero mondo diventa sovrappopolazione relativa causata dall'alta produttività del mondo occidentale. Che cosa succederà quando, con l'aumento della produttività in Cina, India e altri paesi emergenti, l'intero pianeta diventerà serbatoio di sovrappopolazione assoluta? Quando sarà evidente che il Capitale ha superato ogni suo limite e dovrà trattare gran parte dell'umanità come il capitalismo in espansione trattò i pellerossa, sovrappopolazione non sfruttabile, quindi assoluta, dell'epoca? Da tempo diciamo che nel mondo vi sono ormai almeno cinque miliardi di pellerossa. Vi è, anche qui dal punto di vista assiomatico e non delle opinioni, un limite generale a cui deve giungere l'intero sistema prima di collassare (o prima di trasformarsi scattando a livello superiore). Il modello Meadows fu impostato sul culmine del 1975, una data che non a caso coincide con quella che scaturì da un modello elaborato dalla nostra corrente negli anni '50 sulla base degli incrementi decrescenti della produzione industriale (indice pilota, l'acciaio). Siamo effettivamente sul Titanic che affonda, mentre i naviganti si accalcano nella sala da ballo: i grafici mostrano un visibilissimo andamento catastrofico anche quando siano apportate modificazioni molto spinte del sistema, come un controllo demografico globale che stabilizzi la popolazione del pianeta a due figli per coppia a partire dal 1995 (figure 6 e 7). Si può notare, infatti, che pur eliminando una parte della popolazione, la produzione industriale, quella di alimenti, l'inquinamento e il consumo di risorse naturali non variano di molto (i due grafici non sono incompatibili, è solo una differenza di scala sulle ordinate): nel tempo varierà perciò il prodotto medio pro capite, ma non varierà il differenziale di valore fra le fasce più basse di reddito e quelle più alte.

Si dice che l'umanità ha risorse materiali, scientifiche, psicologiche e finanziarie sufficienti per risolvere i problemi, anche se in modo non pianificato e lineare. Non è vero. Oggi vi sono cinque miliardi di persone, su sei e mezzo, con un reddito ben inferiore a quello di chi vive nei paesi più sviluppati. È di nuovo un assioma e non un'opinione affermare che se fossero vere le fole sullo sviluppo ininterrotto, fra pochi anni i cinque miliardi di "pellerossa" (ammesso e non concesso che non aumentino di numero) produrrebbero e consumerebbero a livello americano, cioè 20 volte più di quanto non producano o consumino adesso. Molto, ma molto prima di giungere a quel limite il pianeta esploderà. Infatti le fole sono fole. Uno scenario realistico mostra che, se il capitalismo sopravvivesse fino al 2070, l'esaurimento delle materie prime, l'inquinamento e l'aumento della popolazione produrrebbero un livello di vita medio simile a quello del 1870. E non è finita:

"Considerati dal punto di vista di un osservatore del 2070, gli sforzi dei paesi sottosviluppati per industrializzarsi secondo l'esempio dei paesi occidentali possono apparire dissennati, giacché probabilmente tali paesi si trovano attualmente più vicini alla condizione di equilibrio con l'ambiente di quanto non siano i paesi industrializzati. Rispetto a questi, essi hanno migliori possibilità di superare le incombenti pressioni di carattere economico e ambientale che si preparano per tutto il pianeta; viceversa, i paesi avanzati ne subiscono l'urto in una misura che è proporzionalmente di gran lunga maggiore. Probabilmente quella che stiamo vivendo adesso è un'età dell'oro, nella quale, a dispetto della diffusa sensazione di malessere, la qualità della vita è mediamente più alta di quanto non sia mai stata in passato e di quanto il futuro non ci prospetti" (Forrester, op. cit.).

Alla faccia del progresso: se questa è l'età dell'oro, possiamo immaginare quali potrebbero essere le nefandezze del futuro. Cina e India non hanno certo imboccato la strada dell'equilibrio indicata dai catastrofisti borghesi. Di conseguenza, le cifre che ci giungono sono già ad altissimo potenziale apocalittico: solo in Cina la sovrappopolazione relativa (per adesso fluttuante e latente) è giunta grazie all'industrializzazione rapidissima, a circa 800 milioni di persone, in maggior parte contadini, artigiani e dipendenti pubblici (cfr. Rampini, Il secolo cinese, L'impero di Cindia).

L'econofisica e la sua immediata degenerazione

Era inevitabile: la marcia dell'uomo verso una scienza unificata non poteva essere arrestata dal perdurare del capitalismo sulla scena. Nonostante tutta la potenza di questo mondo cadavere nel separare le conoscenze secondo la divisione tecnica e soprattutto sociale del lavoro, esso non può fermare lo sviluppo della forza produttiva sociale. Così la fisica ha invaso il campo dell'economia politica rivelandone spietatamente la natura di pseudo-scienza. Mentre la meccanica si fermava alle soglie delle discipline umanistiche, la fisica dei fluidi, della complessità, dei campi e delle particelle ha sferrato un attacco frontale all'economia facendo vacillare le barriere entro la conoscenza umana. Oggi le più grandi istituzioni economiche e finanziarie del mondo attingono a piene mani nelle facoltà di fisica e nei politecnici per avere migliaia di esperti in questa materia mentre, paradossalmente, in nessuna università del mondo esiste per adesso una cattedra di econofisica. Il fenomeno è meno strano di quanto possa apparire a prima vista: matematica e fisica sono nate insieme, tanto che sarebbe assurdo separarle nella storia della scienza. In molte discipline sopravvive invece il rifiuto di concepire l'unificazione delle conoscenze, per cui si dice spesso che si "adottano" metodi matematici o fisici per risolvere certi problemi. In fisica e matematica è oggi praticamente impossibile affermare che una delle due discipline ha "adottato" dall'altra metodi per generare modelli della realtà. L'economista Oskar Morgenstern e il matematico John von Newman, che elaborarono la celebre "teoria dei giochi", in un primo tempo pensavano che vi fosse incompatibilità fra discipline così apparentemente diverse come fisica ed economia, ma infine giunsero alla netta conclusione che:

"siccome non si è evidenziata la necessità di principii differenti, sarebbe insensato perseguire le ricerche in un modo diverso da quello che ha portato alla fondazione della fisica" (citato da G. Israel).

Gli elementi dei sistemi fisici complessi raggruppati in specifiche strutture, spesso al limite del caos, e le interazioni fra di essi, hanno rappresentato la premessa alla scoperta di similitudini con i sistemi biologici e sociali. Perciò i fisici dediti a questo settore di ricerca hanno incominciato a ritenere indagabili con i loro metodi settori prima insospettati. Ecosistemi, mercati, reti neurali e colture biologiche hanno rappresentato il campo d'indagine dei fisici di frontiera. Se, come disciplina peculiare, l'econofisica è recente (è fatta risalire per convenzione al 1997-98), deriva tuttavia da ricerche compiute negli anni '80 dal gruppo di Santa Fe per gli studi sulla complessità (se non vogliamo risalire addirittura a Newton che unì le sue osservazioni scientifiche a quelle più pragmatiche in veste di responsabile della Zecca di Stato, che allora era un po' come l'odierna Banca Centrale). In effetti essa esiste da quando esiste il capitalismo moderno: se ne trovano tracce nei nominati Walras e Pareto, ma anche in Poincaré, Bachelier, fino a Mandelbrot. Si può dire, quindi, che le sue origini sono più nobili dei suoi sviluppi degenerati: è assai interessante dal nostro punto di vista, ma è stata praticamente ammazzata dal Capitale, che prima l'ha sminuita applicandola meccanicamente in maniera "interdisciplinare" (il concetto di interdisciplina ribadisce più che mai la divisione in discipline separate che vengono solo fatte comunicare tra loro), e poi l'ha indirizzata quasi esclusivamente verso la ricerca bassamente speculativa di previsioni sui mercati finanziari, specie quelli dei derivati (strumenti finanziari il cui prezzo dipende dall'andamento di attività economiche collegate).

È assai contraddittorio applicare senza scrupoli le leggi della termodinamica, o la teoria dell'informazione, e nello stesso tempo affidarsi a schemi walrasiani di equilibrio. Le prime sono basate sulle distribuzioni statistiche, con grande contenuto empirico; i secondi sono basati sul metodo dell'analisi matematica, con rilevante contenuto teoretico ma non "falsificabili", sono cioè veri di per sé ma non necessariamente aderenti alla realtà politico-economica. C'è un episodio clamoroso e molto celebre a proposito della capacità di applicazione di modelli econofisici: uno dei più grandi fondi di investimento americani, l'LTCM, specializzato in speculazioni sui derivati, fallì miseramente nonostante investisse capitali sulla base delle indicazioni di due premi Nobel, che avevano ottenuto il riconoscimento l'anno prima proprio per un modello di tal tipo (il fondo fu poi salvato dallo Stato, tramite 14 banche private, alla faccia dello sbandierato liberismo).

La disciplina in sé ovviamente non c'entra con l'uso che ne fa il Capitale. Nonostante tutto, essa va in direzione dell'unità fra scienze fisiche e sociali, raggruppando le conoscenze di fisici, matematici, economisti, biologi, informatici, e a noi va bene, come succede tutte le volte che la rivoluzione materiale avanza abbattendo barriere. Se tra fisica ed economia non si è ancora stabilito un legame stretto come tra fisica e biologia, è perché vi è una remora ideologica e, soprattutto, perché sopravvive un modo di produzione legato allo scambio tra valori sul quale indagare per trarre profitto: "L'economia è una scienza truccata. Fa finta di essere scienza generale e astratta delle decisioni razionali. In realtà è scienza dei soldi e del loro fruttare", dice un economista italiano (Castelfranchi). Tutto questo naturalmente sullo sfondo del fatto che esiste un'economia politica. Tuttavia il processo in corso è interessante per noi appunto perché è in grado di dare risposte sull'origine della miseria e della sovrappopolazione, risposte che abbiamo la possibilità di slegare completamente dal contesto nel quale e per il quale sono utilizzate dalla borghesia.

La fisica dei sistemi complessi comprende escursioni nei campi dei sistemi dinamici, delle interazioni stocastiche (casuali), della termodinamica, della teoria dei frattali, della teoria dei giochi, di quella delle reti, dell'informazione, ecc., per cui è possibile trattare ad esempio la distribuzione del reddito come l'andamento di un sistema perturbato vicino a una transizione di fase (ebollizione, congelamento, ecc.), o una crisi economica come se fosse un modello di catastrofe (cedimento di una struttura, terremoto, ecc.).

Parte seconda: un modello di miseria crescente

De-ideologizzare la capitalistica "distribuzione del reddito"

In questa seconda parte chiederemo al lettore un piccolo sforzo di astrazione per seguire il modello formale preso in esame. Come diceva un vecchio rivoluzionario, la militanza comunista non è fatta per i "pelandroni" che aborrono gli schemi e i numeri. Non vi sono qui difficoltà matematiche o d'altro genere e abbiamo cercato di evitare un linguaggio per iniziati, senza però concedere nulla alla volgarizzazione. Comunque sia, lo sforzo dovrebbe essere abbondantemente ripagato dalla gran quantità di informazione che il lettore potrà ricavare dai capitoletti che seguono.

L'analisi di un sistema economico come quello capitalistico, della sua dinamica e del suo impossibile equilibrio (o delle condizioni teoriche di equilibrio negate nella prassi) è quanto mai complessa se non si parte da un'astrazione, basata su leggi d'invarianza, che unifichi i più disparati aspetti dei fenomeni interni al sistema stesso. Così l'analisi di una azienda si riflette in quella di una sfera della produzione, la quale si riflette in quella di un paese e questa in quella del mondo. In un certo senso abbiamo una struttura "frattale", un'invarianza nonostante la diversa scala dei fenomeni. Nello stesso tempo abbiamo una dialettica delle differenze, dato che se il denaro è tale sia nell'antica Grecia che negli attuali Stati Uniti, tra la dracma e il dollaro corre la differenza che c'è fra un materiale pezzo d'argento e lo spersonalizzato, anonimo Capitale che fluisce sulle reti telematiche. L'invarianza ci aiuta a modellizzare, mentre l'elemento qualitativo che costituisce la differenza va ricondotto a unità adimensionali di valore quantificabili.

Abbiamo visto come la matematica prima, e la fisica poi, abbiano invaso il campo dell'economia. Da questo punto di vista è bene precisare qui ciò cui abbiamo già accennato: nel corso della marcia verso una conoscenza unificata, l'invasione di campo tra discipline è un fatto provvisorio dovuto all'altrettanto provvisoria separazione operata dalla società borghese, all'inizio rivoluzionaria (riduzionismo cartesiano) oggi reazionaria. In altre società il mondo fisico non era affatto separato da quello sociale, e la divisione del lavoro, pur presente in epoche antichissime, non era paragonabile a quella di oggi. S'è detto che matematici e fisici hanno "invaso" il campo dell'economia politica ben prima che si pensasse a istituire cattedre di econofisica: una società dinamica come il capitalismo ha bisogno di "applicazioni" a ritmo accelerato e non può certo aspettare che l'ideologia intralci le possibilità di fare profitti. La diffidenza degli economisti verso i metodi di indagine provenienti dall'esterno rispetto alla loro disciplina non ha quindi senso, e ogni resistenza è già sconfitta nei fatti. Il citato Krugman, ad esempio, è uno di quegli economisti "umanisti" che nega la possibilità di riprodurre con mezzi formali la contraddittoria realtà economica. Ora, è vero che non si possono riprodurre i caratteri della società in un laboratorio reale, come si fa in fisica quando si cerca la verifica sperimentale degli assunti teoretici; ed è anche vero che gli strumenti formali offerti dalle discipline scientifiche "soffrono" dal punto di vista dell'ideologia tanto quanto l'economia politica, dato che essi sono sviluppati da uomini di questa società; ma, come abbiamo visto sulla base degli assunti galileiani sempre validi, non vi è che la formalizzazione, matematica o di altro tipo, per separare ideologia e ricerca; se utilizzata in modo appropriato essa è una "vera macchina per conoscere" come si dice in un nostro testo storico (Elementi). E il suo utilizzo ci mette nelle stesse condizioni del ricercatore di laboratorio.

Prenderemo quindi in esame un modello di distribuzione del reddito (cfr. Bennati, Il metodo di Montecarlo nell'analisi economica e La simulazione statistica ecc.), risalente a qualche anno fa, scritto direttamente in uno dei linguaggi correnti di programmazione al computer e scaturito dall'esigenza di superare le difficoltà incontrate con il metodo dell'analisi matematica e del calcolo probabilistico tradizionali. Questi metodi in pratica avevano offerto un troppo basso grado di realismo, cioè un divario inaccettabile fra analisi teorica e osservazione empirica, quindi un basso grado di predittività. Di qui la ricerca di una diversa via.

Nel modello che sottoporremo al lettore, si adotta la "simulazione di Montecarlo" (metodo nato negli anni '40 e utilizzato oggi in fisica, chimica, biologia, ecc.), la quale, va detto subito, non ha niente a che fare con il "marxismo" inteso come politica specifica dei rivoluzionari ecc. ecc., ma è applicabile universalmente a qualsiasi fenomeno della natura che comporti la possibilità di utilizzare l'analisi statistica (e la società umana è semplicemente uno di questi fenomeni). Ad essa si ricorre quando i problemi non sono risolvibili con gli strumenti tradizionali di formalizzazione, sia per la complessità del fenomeno che per il numero dei parametri in gioco o per le lacune della teoria in via di verifica.

Si tratta di un sistema, simulato al computer, al cui interno agiscono determinate leggi. Per il solo fatto che queste leggi esistano e agiscano in modo da determinare la dinamica della simulazione con i suoi risultati, abbiamo un modello probabilistico ma strutturato, nel quale non vi è nulla di indeterministico in senso ideologico. Del resto fisici e matematici sono ormai quasi tutti concordi nel riconoscere che anche i fenomeni più complessi e caotici non sono di tipo indeterministico e che l'ordine emergente non è "creazione" ma "auto-organizzazione" dovuta alle determinazioni interne del sistema. Di più: le interazioni casuali determinate da un programma di computer, confermano in via teoretica il nostro assunto materialista di partenza. Se c'è un programma, anche quando si ottiene un disordine voluto a partire da una situazione iniziale ordinata, allo scopo di scoprire una configurazione di ordine superiore o comunque diverso, allora siamo sicuri che agiscono determinazioni soggiacenti; il che vuol dire, al solito, che esistono "leggi". Infatti nel saggio citato si fa una dichiarazione di principio importante:

"Tali leggi non si riferiscono solo alle relazioni funzionali esplicative del modello ma anche ai meccanismi di interazione casuale che non si è in grado o non si vuole specificare".

Le componenti del sistema, simulato secondo i parametri di partenza e le citate leggi, vengono fatte interagire. L'azione delle forze casuali che operano entro un quadro di vincoli imposti porta infine il sistema ad un'altra configurazione, la quale può essere di equilibrio o di caos, ma sempre molto indicativa rispetto alla sua dinamica, che è poi quella su cui si deve indagare per trarre conoscenza rispetto alla realtà simulata. Infatti, prima ancora di immettere nel modello nuove informazioni che ne fanno variare il comportamento, già in questa fase ad alto livello di astrazione (semplificazione) è possibile verificare il realismo della simulazione rispetto al mondo oggettivo, ricavarne indicazioni per eventuali messe a punto, individuare quali sono gli elementi cui il modello stesso è più sensibile.

Nel caso dell'economia, ad esempio, si possono inserire informazioni sull'ambiente politico più o meno in grado di prendere determinate decisioni, le quali possono far evolvere il modello secondo percorsi che variano col variare della sua sensibilità alle condizioni iniziali piuttosto che a una situazione già evoluta. Come nel caso reale del sistema capitalistico, che ha adottato irreversibilmente lo statalismo industrial-finanziario (keynesismo) e ora, dopo l'iniziale successo e il presunto fallimento finale, vorrebbe ritornare a un liberismo di mercato mai realmente esistito. Da questo punto di vista la "simulazione statistica" tramite modelli si presenta dunque come un vero e proprio esperimento di laboratorio, e i suoi risultati possono essere interpretati come una realtà riproducibile artificialmente, quindi in linea teorica prevedibile e modificabile.

La legge universale e i suoi aspetti particolari

La simulazione di Montecarlo applicata all'economia è particolarmente calzante: la società umana può essere riprodotta in quanto costituita da "particelle" o "cellule" interagenti le cui condizioni iniziali entro il sistema non contemplano un giudizio di classe precostituito ma una situazione di equilibrio. La situazione di classe, con le relative differenze fra "gruppi" di particelle, emerge, facendole interagire ripetutamente. È interessante notare che questo aspetto della simulazione nel frattempo era emerso anche con i modelli sociali basati su analogie biologiche in margine agli studi sulla complessità o sulla teoria delle reti (cfr. Waldrop, Kauffman, Barabàsi).

Quei modelli erano concettualmente analoghi ai modelli derivati dalla dinamica dei sistemi visti nei capitoletti precedenti, ma differenti rispetto alla meccanica interna per giungere al risultato: i primi si fondavano su equazioni di equilibrio, i secondi si fondano su metodi stocastici (evidentemente la legge di Marx sulla miseria crescente è l'aspetto particolare di una legge universale). L'autore dello studio cui ci stiamo riferendo insiste sull'universalità del metodo, e spiega la scelta della distribuzione del reddito come campo di indagine con il fatto che esistono una vasta documentazione statistica sull'argomento (utilizzabile per la verifica empirica) e un'altrettanto vasta produzione di studi specifici, e soprattutto la spiega con il fatto che la curva tipica della distribuzione del reddito ha caratteri analoghi nelle situazioni più disparate in ogni parte del mondo e in ogni epoca (condizioni geostoriche, diremmo con il nostro linguaggio; è ovvio che il solo esistere di questa invarianza suggerisce di nuovo la presenza di una legge). Infine, annota l'autore, nonostante la gran quantità di studi,

"Il dibattito sui fondamenti teorici della distribuzione è tuttora aperto: i tentativi intrapresi per legare teoria e realtà non hanno dato risultati soddisfacenti in quanto i parametri esplicativi della curva hanno giustificazione matematica ma non sono in grado di individuare le forze economiche che la determinano".

Per poter individuare queste forze economiche, è necessario rappresentare la realtà tenendo conto di un numero elevato di parametri, soprattutto quelli riguardanti la natura dello scambio, i comportamenti degli individui e degli aggregati (classi), i processi di produzione e distribuzione del reddito entro la società, la dinamica espansiva o recessiva dell'intero sistema. L'impossibilità di riprodurre questa realtà complessa con il solo ausilio tradizionale dell'analisi matematica ha comportato una stagnazione nella ricerca teorica che, sommata al blocco dovuto puramente a ragioni ideologiche, ha sviato l'attenzione dalle gravi conseguenze dei problemi connessi al modo in cui il reddito si distribuisce nella società, sia dal punto di vista "spontaneo" sia dal punto di vista "pilotato" tramite l'intervento statale (imposte, investimenti pubblici, ecc.).

Il modello basato sul metodo di Montecarlo permette invece di implementare un gran numero di parametri senza essere condizionati dai limiti dell'analisi matematica; di mettere in risalto le variabili economiche significative confrontando la teoria e la prassi; di verificare nel tempo simulato l'effetto degli interventi sull'evoluzione del sistema, ecc. Soprattutto permette di superare il dualismo fra micro e macroeconomia, collegando direttamente quest'ultima al comportamento dell'individuo.

Mentre Pareto aveva cercato la funzione di distribuzione del reddito che meglio si approssimava alla realtà, deducendola dall'esperienza empirica, il modello in questione permette di individuare i fenomeni che stanno alla base dell'effettiva distribuzione del reddito entro la società e di determinare quanto sia sensibile una situazione data al variare dei fenomeni stessi. In pratica Pareto aveva tentato di individuare una legge che giustificasse la forma della curva statistica di distribuzione del reddito, la sua stabilità anche nel lungo periodo, mentre il nostro modello riproduce la realtà che genera quella curva come se si fosse in laboratorio.

Naturalmente i limiti imposti dall'analisi matematica possono essere superati solo con altri metodi di modellizzazione, accertando correttamente le forze economiche agenti nella società reale e simulata, studiando sistematicamente il loro modo di agire e traducendo in quantità misurabili la loro influenza, analizzando gli effetti della loro evoluzione nel tempo e delle sollecitazioni "esterne" (interventi mirati di politica economica) sulla dinamica dell'intero sistema.

Primo passaggio: massimo di astrazione

Il metodo seguito per la simulazione prevede tre fasi generali: 1) la genesi del modello a partire da un nucleo elementare; 2) la sua dinamizzazione evolutiva; 3) la corretta valutazione dei risultati ottenuti.

In una prima fase, dunque, è stato implementato al computer un modello di simulazione del reale con parametri comuni anche a una formalizzazione di tipo analitico. Si tratta di verificare l'attendibilità del metodo con i comuni risultati ottenuti per vie diverse. In questa fase l'obiettivo è descrivere il metodo attraverso un caso particolarmente semplice, caso che servirà da base per la costruzione del modello finale in grado di simulare la realtà economica con elevata oggettività. Si parte da un sistema economico chiuso, formato da 1.000 individui, con una "ricchezza" pro capite di 10 espressa in unità arbitrarie. Il reddito di partenza è quindi distribuito in maniera uniforme fra le cellule sociali. Il computer (il programma) terrà conto di questa situazione, e non dovrà far altro che aggiornare, secondo dati parametri, lo "stato" di ogni cellula sociale al momento della sua interazione con le altre. Il sistema di partenza è semplificato al massimo, quindi lo scambio fra due individui prevede soltanto il cedere o il ricevere una unità di ricchezza secondo criteri del tutto casuali e a pari probabilità.

Le coppie di individui sono selezionate a caso dal computer, che modifica il loro stato aggiungendo unità di ricchezza all'uno e togliendola all'altro. Quando un individuo raggiunge ricchezza zero, l'operazione su di esso non viene attuata. Come si può notare, il modello non presenta alcuna difficoltà di comprensione anche per il profano e, anzi, sembra talmente banale da suscitare dei dubbi sulla sua utilità pratica. Sono infatti assenti categorie sociali di qualunque genere, sia dal punto di vista borghese che dal nostro: siamo di fronte a una specie di brodo di coltura primordiale in cui organismi unicellulari assai poco strutturati si muovono con elementari scambi di energia (questo paragone biologico è utile per capire l'analogia con gli studi sulla teoria dei sistemi, iniziati proprio con l'osservazione del mondo dei batteri e continuati recentemente a proposito dei fenomeni che in generale vengono raggruppati sotto il nome di "complessità", cfr. i citati Waldrop, Kauffman, Barabàsi). Nonostante la sua semplicità, il modello è comunque già in grado di offrire indicazioni non banali e rappresentare una pietra di paragone per sistemi molto più complessi, come vedremo.

Per visualizzare graficamente il processo sulla pagina stampata, esso è stato ulteriormente semplificato. Nelle figure 8, 9, 10 e 11 sono riprodotte le fasi di una simulazione grafica riferita a un sottoinsieme di soli 256 individui (16*16), rappresentati dai quadrati di una griglia, ognuno contenente un numero di punti pari alla ricchezza posseduta (in questa semplificazione, 3 unità). La condizione iniziale del sistema è dunque: ricchezza media 3, distribuzione uniforme, istogramma relativo con una sola fascia di reddito (i grafici delle figure da 8 a 20 sono rilevati direttamente dal file originale inviatoci gentilmente dall'autore).

Iniziano le interazioni casuali secondo le semplici leggi prima descritte: alcune unità di ricchezza si aggregano ad alcuni individui, mentre si allontanano da altri; l'istogramma mostra un allargamento statistico centrale intorno al valore 3 con una classica curva a campana (gaussiana); all'aumentare delle interazioni nel tempo, la fascia centrale si allarga e la curva assume una forma sempre più simile a quella di Pareto, già osservata. Aumentano gli scarti di ricchezza rispetto alla media, specie nella fascia dei valori alti, mentre gli scarti verso il basso sono minori, in quanto si è assunto che non vi può essere un individuo con ricchezza negativa (nella realtà gli individui si possono indebitare, ma in questo caso si assume che il debito equivalga a ricchezza supplementare della fascia alta).

Tale semplice meccanismo produce già una diseguaglianza "sociale" simile a quella della realtà: nella scansione temporale diminuiscono i "ricchi", si allarga temporaneamente la fascia intermedia (in pratica si appiattisce la curva nella sua parte centrale) e infine aumenta semplicemente quella dei "poveri". Dato che si è innescata una dinamica nello spostare la ricchezza iniziale, ecco che compare, per chi riceve, il concetto di reddito.

La situazione conclusiva è espressa da una curva esponenziale decrescente che non è più sensibile ad ulteriori interazioni: il sistema ha raggiunto il suo equilibrio (ovviamente in assenza di reazioni sociali). La successione degli scenari, per quanto ultra-semplificati, ci indica uno degli aspetti contro-intuitivi di cui abbiamo parlato: un approccio "ingenuo" porterebbe a pensare che la situazione stabile sia quella di figura 8, cioè quando la ricchezza è distribuita in modo uniforme nella società e ogni individuo dispone esattamente della ricchezza media. Invece la situazione stabile, di equilibrio del sistema, è quella di figura 11, quando si ha la massima asimmetria nella distribuzione.

Detto in altri termini: in un sistema in cui lo scambio, anche casuale, preveda una qualsiasi distribuzione di valore, il solo fatto di non permettere che un individuo muoia di fame (blocco dell'interazione quando si raggiunge reddito zero, impossibilità del reddito negativo), distrugge l'ipotesi che vi sia una distribuzione classica a campana, come in altri fenomeni della natura. La tendenza intrinseca del sistema è verso la cristallizzazione di un'alta asimmetria sociale. Per quanto l'economista Krugman sia contrario alle formalizzazioni spinte, questa simulazione dimostra proprio il suo assunto centrale: le fasce intermedie di ricchezza/reddito tendono inesorabilmente ad estinguersi.

Figura 8. Situazione di partenza, distribuzione uniforme della ricchezza.

Figura 8. Situazione di partenza, distribuzione uniforme della ricchezza. Figura 9. Situazione dopo 500 interazioni (istogramma 2):

l'andamento è già asimmetrico. Notare che all'interazione 400 la distribuzione

ha mostrato temporaneamente una curva quasi gaussiana (a campana).

Figura 9. Situazione dopo 500 interazioni (istogramma 2):

l'andamento è già asimmetrico. Notare che all'interazione 400 la distribuzione

ha mostrato temporaneamente una curva quasi gaussiana (a campana). Figura 10. Dopo 900 interazioni (istogramma 1) e 1000

(istogramma 2 e quadrato grande) la curva diventa decisamente asimmetrica. La

rappresentazione "sociale" implicita nel quadrato grande mostra già

35 caselle vuote (con ricchezza nulla) e 3 caselle piene (con reddito accumulato

= ricchezza maggiore di 9).

Figura 10. Dopo 900 interazioni (istogramma 1) e 1000

(istogramma 2 e quadrato grande) la curva diventa decisamente asimmetrica. La

rappresentazione "sociale" implicita nel quadrato grande mostra già

35 caselle vuote (con ricchezza nulla) e 3 caselle piene (con reddito accumulato

= ricchezza maggiore di 9). Figura 11. Dopo 2400 interazioni (istogramma 1) la

distribuzione è già esponenziale, con qualche fluttuazione. Dopo 2500

(istogramma 2 e quadrato grande) l'andamento esponenziale è netto con

ammassamento a reddito zero e "coda" verso reddito dieci.

Figura 11. Dopo 2400 interazioni (istogramma 1) la

distribuzione è già esponenziale, con qualche fluttuazione. Dopo 2500

(istogramma 2 e quadrato grande) l'andamento esponenziale è netto con

ammassamento a reddito zero e "coda" verso reddito dieci. Figura 12. Distribuzione del reddito ottenuta dopo 100.000

interazioni per un sistema composto da 1.000 individui e con ricchezza media 10.

Si osservi l'andamento fluttuante intorno alla curva esponenziale teorica che

interpola il risultato della simulazione.

Figura 12. Distribuzione del reddito ottenuta dopo 100.000

interazioni per un sistema composto da 1.000 individui e con ricchezza media 10.

Si osservi l'andamento fluttuante intorno alla curva esponenziale teorica che

interpola il risultato della simulazione. Figura 13. Media di 10.000 istogrammi registrati in

simulazioni diverse dopo che si è raggiunta la situazione di equilibrio data in

figura 5. Il risultato statistico approssima perfettamente la curva esponenziale

teorica.

Figura 13. Media di 10.000 istogrammi registrati in

simulazioni diverse dopo che si è raggiunta la situazione di equilibrio data in

figura 5. Il risultato statistico approssima perfettamente la curva esponenziale

teorica.Aumentando il numero degli individui e la loro ricchezza individuale media alle condizioni iniziali, si aumenta il grado di realismo del sistema. Con 1.000 individui e con ricchezza pro capite media 10, la stabilizzazione del sistema si ottiene dopo 100.000 interazioni casuali (figura 13). Non ci si discosta dai risultati precedenti, a parte l'affinamento dei dati, ma l'istogramma che rappresenta la situazione reale simulata non corrisponde ancora pienamente alla curva teorica, quella che si otterrebbe per pura via analitica. Occorre quindi ripetere più volte la simulazione su sistemi equivalenti e calcolare la media dei risultati.

A questo punto si ha una perfetta aderenza fra l'istogramma della realtà simulata col metodo delle interazioni fra individui (interazioni regolate dalle leggi interne del sistema) e la curva della realtà simulata per via matematica (con un procedimento che si chiama "distribuzione di Boltzmann" e che risale al famoso scienziato; nel testo originale c'è la dimostrazione matematica per esteso). La curva ottenuta per via analitica offre una verifica teoretica della simulazione al computer, ma ci si potrebbe chiedere − osserva l'autore − a che cosa serva quest'ultima se con lo strumento matematico si può raggiungere lo stesso risultato, per di più con un metodo "esatto" che non prevede l'oneroso impegno di macchine, programmatori e operatori, come invece quello statistico.

La risposta è che questo primo livello di simulazione permette di verificare quanto il modello al computer sia uno strumento efficace e corretto; dopo di che, la concordanza dei dati ottenuti attraverso le due vie permette di gettare le basi per un ampliamento della simulazione verso approssimazioni sempre più realistiche al fenomeno da indagare.

Secondo passaggio: critica ai limiti dell'econometria

Per rendere il modello più aderente al mondo reale – spiega l'autore – bisognerebbe introdurre nella simulazione vincoli e leggi di natura micro e macro-economica, ad esempio limitando la casualità nello scambio tra individui, tassando e redistribuendo il reddito, attribuendo memoria ai soggetti in modo che il loro comportamento si modifichi rispetto a precedenti risultati; oppure, come succede nella maggior parte dei sistemi complessi, legando il comportamento dell'intero sistema alle informazioni ricavabili dalla sua stessa dinamica.

Tutte queste varianti al modello ne potenziano la capacità semplicemente aggiungendosi alla struttura di base tramite apposite istruzioni al programma, senza peraltro modificarne il concetto generale. Un simile potenziamento però è impossibile attraverso il metodo analitico matematico, che ha dei limiti oltre i quali la strada della simulazione verso un realismo spinto è bloccata: il caso più eclatante è la sua impossibilità di attribuire memoria storica degli eventi alle istituzioni e agli individui simulati, con relativo feedback ed effetti non lineari; che costituiscono invece uno dei caratteri specifici e più importanti proprio dei sistemi sociali.

Eppure il metodo analitico ebbe un tale successo che, nonostante i suoi limiti, ancora oggi è ritenuto − ed è − fondamentale in campo economico. Quando Marx scrive l'equazione del saggio di profitto e dimostra la caduta storica tendenziale di quest'ultimo, non fa che formalizzare le relazioni economiche in modo da rendere "misurabile l'economia", come dice il nome stesso della scuola che tenta di ricavare dalla realtà gli algoritmi in grado di rappresentarne un modello astratto le cui relazioni siano trattabili con metodo quantitativo (econometria). A parte Marx, che ricava dai rapporti matematici quelli di classe, entro tale definizione cadono anche rami dell'economia politica che a rigore non fanno parte della scuola econometrica. Oggi, anzi, con l'econometria "applicata", nata alla fine degli anni '50 insieme con i primi elaboratori elettronici commerciali, le discipline si sovrappongono in modo inestricabile (cfr. Klein).

Comunque, punto forte dell'econometria è sempre stato quello di ridurre le relazioni economiche a modelli teorico-analitici, approccio attraverso il quale passa il metodo comparativo del lavoro in esame. In un certo senso anche in nostri due Quaderni (cfr. Crisi storica del capitalismo senile e Dinamica dei processi storici – Teoria dell'accumulazione) abbiamo adottato il metodo comparativo, sovrapponendo le curve ottenute con il computer per via teorico-analitica a quelle tratte dai dati ufficiali sull'andamento economico (in quel caso però non si trattava di grafici di distribuzione statistica, ma di variazioni nel tempo di alcuni parametri economici).

Come si è detto, la curva paretiana di distribuzione del reddito è presente in ogni sistema capitalistico locale e si ripresenta a livello di economia mondiale. L'interesse nell'individuazione delle radici teoretiche di tale curva sta proprio nel fatto che essa descrive universalmente moltissimi fenomeni ed è per di più caratterizzata da pochi parametri. Applicata all'Inghilterra di fine '800 corrispondeva in modo "eccellente" alla realtà (tuttavia lo stesso Pareto aveva notato vent'anni dopo, sulla base di nuove statistiche, che la sua "legge" aveva dei limiti, gli estremi della curva si discostavano dai dati empirici, soprattutto dalla parte dei redditi molto bassi). Oggi, osserva l'autore, la corrispondenza tra curva e realtà è peggiorata, dato che riguarda solo un 30% circa della zona medio-alta. Se questo fatto fosse provato, confermerebbe clamorosamente l'assunto marxista della miseria crescente nel lunghissimo periodo. Infatti tutti i lavori statistici recenti dimostrano che il vero problema sociale è precisamente nel peggioramento continuo della parte di curva che descrive i redditi bassi, dato che in qualunque paese la percentuale della popolazione con reddito al di sotto della media non è mai inferiore al 60-65%.

Nella ricerca vengono riportati alcuni esempi, tratti dalla pubblicistica economica, per provare che la legge di Pareto è valida universalmente solo se si corregge, appunto, la parte della curva che riguarda i redditi bassi e il loro numero. Il modesto riscontro con le rilevazioni empiriche è dovuto al fatto che nella realtà sembra non esistano individui a reddito zero, mentre la curva li registra. In effetti nella realtà vi sono moltissimi individui a reddito zero, solo che non muoiono di fame perché in qualche modo beneficiano di una ripartizione del reddito (come milioni di giovani disoccupati che vivono alle spalle della famiglia fino a trent'anni, ecc.).

Quel che è interessante, anche dal nostro punto di vista, è che, all'approccio puramente analitico, l'autore non ritiene di opporre un approccio puramente statistico, ma ricava importanti conclusioni proprio dal confronto con le curve teoriche (esponenziale, a campana e paretiana) di distribuzione del reddito, le stesse che sono deducibili dal modello semplice di partenza, che conduce alla curva esponenziale di figura 13. Anche in questo caso abbiamo una conferma indiretta dell'assunto marxiano: rispetto al rilevamento statistico sul campo, la curva esponenziale tenderebbe a sottostimare il numero degli alti redditi e a sovrastimare il numero di quelli bassi. Nel testo non ci si sofferma sulle ragioni del divario fra curva teorica e rilevamento dei dati, ma sappiamo che nella realtà sono operanti sia gli effetti della redistribuzione, sia quelli più tipicamente ideologici dei parametri di rilevamento, che influenzano tabelle e curve.

Il presidente dell'ISTAT ha denunciato recentemente che il metodo attuale di rilevamento dell'inflazione è decisamente classista, dato che si basa sui prezzi al consumo indipendentemente dalle classi di reddito. È chiaro infatti che se aumentano i prezzi del pane e degli affitti sono più colpite le classi per le quali queste sono voci di spesa importanti. La miseria crescente si misura quindi anche sulla forbice fra i prezzi industriali, in storica diminuzione, e i prezzi agrario-immobiliari, che per il proletario costituiscono il valore di mercato dell'intero salario, cioè della forza-lavoro, in storico aumento (con quelli delle tariffe, energia, telefono, trasporti, ecc.).

Tuttavia la curva esponenziale di distribuzione, pur non rappresentando esattamente la realtà economica, è comunque un punto di riferimento teoretico migliore delle "normalizzazioni" sulla curva di Pareto operate dagli economisti presi a confronto. Essa infatti è ricavata da ipotesi tanto generali da essere valida universalmente; scaturisce sia da un semplice modello statistico di scambio casuale come quello analizzato in precedenza, sia da un modello analitico che debba essere descritto con la minor quantità di informazione possibile. E siccome in ogni caso si perviene sempre all'equazione che descrive la curva di figura 13, il ricercatore ha a disposizione un potente algoritmo di base.

Rimane dunque il fatto che entrambi i sistemi, quello dinamico semplificato e quello descritto dall'equazione della curva esponenziale, possono stare alla base di un ulteriore avvicinamento alla realtà. Solo che ad un certo punto conviene abbandonare l'equazione e puntare sul modello statistico che pure ne deriva. Qui l'autore dimostra come il tentativo di arricchire la formulazione generale con l'introduzione di ipotesi aggiuntive (ad esempio la sostituzione dello scambio casuale con un indicatore della capacità di attrarre reddito da parte di un reddito già elevato) abbia grossi limiti. E dimostra l'assunto di cui sopra secondo il quale i dati sono matematicamente ricavabili, ma allo stesso tempo che ciò non basta a spiegarne la natura economica derivante dallo scambio di valore.

Lo stesso discorso è ripetuto nel caso della curva di distribuzione "normale" (a campana o gaussiana), ottenibile tramite semplici fluttuazioni dei dati intorno a una media, e anch'essa (soprattutto essa, tradizionalmente) descrivibile in via analitica. Siccome in questo caso non vi sono altri parametri "liberi" oltre al numero degli individui del sistema, al loro reddito medio e allo scostamento da esso, il suo aspetto non può che essere preminentemente simmetrico. Nonostante abbia ottenuto un certo successo all'inizio del '900, tale curva entra in grave contraddizione con l'osservazione empirica, che dà una curva assai asimmetrica. Per di più la "coda" degli alti redditi, con basso numero di coloro che li percepiscono nella realtà, si proietta ben al di là anche di una curva gaussiana "deformata".

Figura 14. Rappresentazione grafica di una distribuzione di

reddito teorica caratterizzata da una curva basata non sul reddito ma sul suo

logaritmo. Il numero dei percettori è 1000 e il valore medio del reddito

percepito 10.

Figura 14. Rappresentazione grafica di una distribuzione di

reddito teorica caratterizzata da una curva basata non sul reddito ma sul suo

logaritmo. Il numero dei percettori è 1000 e il valore medio del reddito

percepito 10.Per avvicinare l'aspetto della curva teorica a quello della curva reale si possono correggere i "difetti" delle curve precedenti, ad esempio distribuendo il reddito secondo il criterio gaussiano: non però segnando sull'asse orizzontale la semplice progressione del reddito, ma adottando un criterio che tenga conto dell'asimmetria reale, cioè della citata "coda" verso i redditi alti percepiti da pochi. Criterio che, nello studio in esame, è il logaritmo del reddito. Il risultato lo si vede nella figura 14. L'aspetto non è ancora quello della curva reale: all'origine vi sono zero individui con zero reddito, e verso i redditi alti il decrescere del numero di chi li percepisce è ancora troppo rapido (troppi individui spostati verso la fascia media). Tuttavia il risultato è migliore dei due precedenti, dato che la distribuzione gaussiana a scala corretta si approssima abbastanza bene a quella rilevata empiricamente. Nelle figure 15, 16 e 17 diamo degli esempi di curve dedotte dai dati reali.

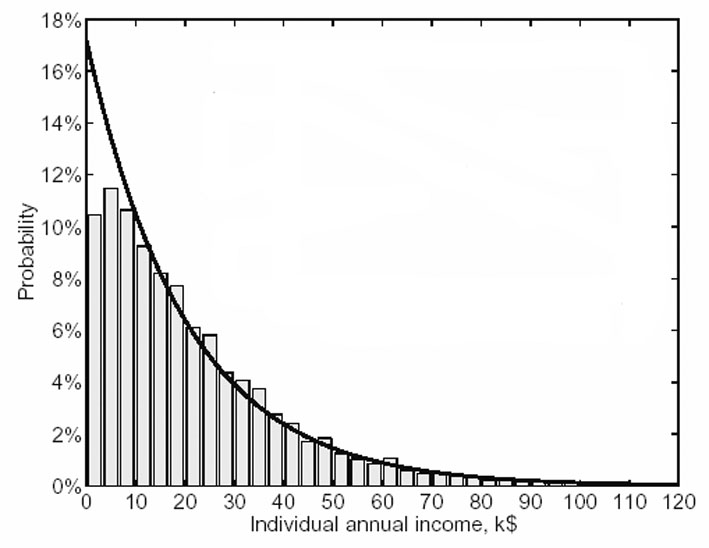

Figure 15 e 16. Reddito individuale e delle famiglie in USA

nel 1996 (in verticale le percentuali della distribuzione). Istogrammi ricavati

dai dati empirici e curve teoriche sovrapposte. Nel primo caso la realtà mostra

un'esponenziale approssimata; nel secondo una classica curva di Pareto quasi

perfettamente sovrapposta. Le ragioni di questa differenza qualitativa sono

controverse: dal punto di vista puramente fisico essa indicherebbe un

comportamento casuale (entropico) dei singoli agenti e un comportamento

governato da rovesciamento della prassi nelle loro famiglie (cfr.

Dragulescu-Yakovenko).

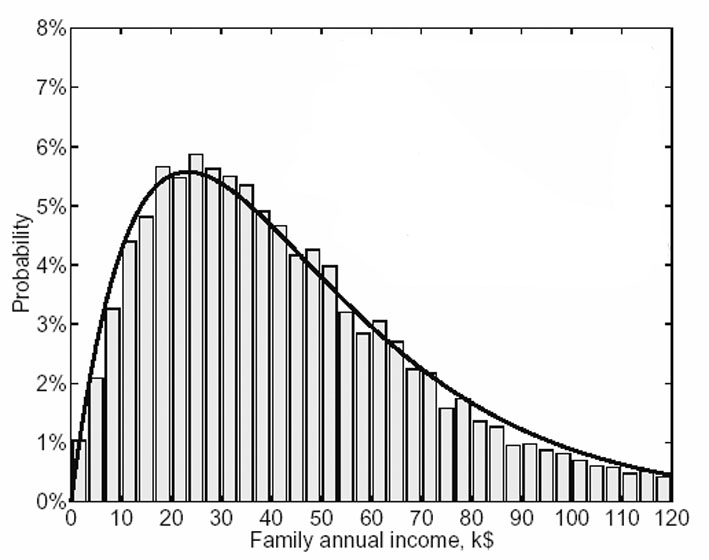

Figure 15 e 16. Reddito individuale e delle famiglie in USA

nel 1996 (in verticale le percentuali della distribuzione). Istogrammi ricavati

dai dati empirici e curve teoriche sovrapposte. Nel primo caso la realtà mostra

un'esponenziale approssimata; nel secondo una classica curva di Pareto quasi

perfettamente sovrapposta. Le ragioni di questa differenza qualitativa sono

controverse: dal punto di vista puramente fisico essa indicherebbe un

comportamento casuale (entropico) dei singoli agenti e un comportamento

governato da rovesciamento della prassi nelle loro famiglie (cfr.

Dragulescu-Yakovenko). Figura 17. Distribuzione del reddito in Italia secondo le percentuali dedotte dalle

aliquote fiscali 2006. Anche in questo caso all'istogramma si sovrapporrebbe la

curva paretiana (fonte: Agenzia delle Entrate).

Figura 17. Distribuzione del reddito in Italia secondo le percentuali dedotte dalle

aliquote fiscali 2006. Anche in questo caso all'istogramma si sovrapporrebbe la

curva paretiana (fonte: Agenzia delle Entrate).Può lasciare perplessi l'apparente arbitrarietà nell'utilizzare non le variabili ma il loro logaritmo, come per giungere comunque al risultato voluto. L'osservazione ha un certo fondamento, e l'autore lo riconosce. Tuttavia fa notare che il ricorso a questo espediente non deriva soltanto dalla necessità di far combaciare le curve (cosa che sarebbe di per sé giustificata, nel contesto della ricerca), ma è tipico della ricerca nel campo delle scienze della natura, in quanto gran parte dei fenomeni naturali sono misurabili solo su scala logaritmica. L'osservazione fenomenologica si rivela dunque fondamentale anche se utilizzata per giustificare a posteriori un assunto teoretico. Rimane il fatto che anche in questo caso, nonostante un'approssimazione alla realtà migliore che negli altri due casi, il modello analitico non rende conto del significato economico-sociale dei parametri utilizzati. Da una parte è un modello potente per la sua universalità; ma, dall'altra, l'impossibilità di essere applicato a un fenomeno specifico senza perdere le sue caratteristiche (cfr. tabella di confronto fra metodo analitico e sistemico) ne blocca il percorso "dall'astratto al concreto" una volta che si sia giunti all'astrazione tramite l'osservazione del reale; percorso che già Marx indicava come completamento dell'indagine scientifica.

A dimostrazione della semplice legge assiomatica della miseria crescente e della sovrappopolazione relativa, a noi basterebbero già i risultati cui siamo pervenuti finora. L'autore va però ben oltre, tanto da far apparire il suo lavoro, a leggerlo con occhi marxisti, non una mera esercitazione universitaria per addetti ai lavori, ma quasi un manifesto politico.

n+1

n+1